« 1

2

3

4

5

»

Идея создания своих сайтов на .NET 9 довела до проблемы как быстро обновлять проект после билда. В Web Forms всё просто:

1. Сохранил изменения.

2. Ctrl + B.

3. Обновил страницу.

Но Web Forms устарели и там нет будущего. В .NET Core всё сложнее, то файл процессом занят и нельзя перезаписать, то ещё что-то. Путём экспериментов нашёл способ:

1. В каталоге куда ссылается сайт в IIS создаёшь файл app_offline.html

2. Копируешь обновлённые файлы.

3. Удаляешь app_offline.html

4. Обновил страницу, смотришь изменения.

Надо написать сценарий автоматической доставки в локальный IIS после билда.

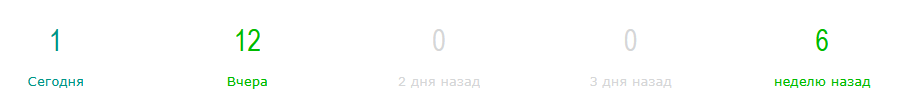

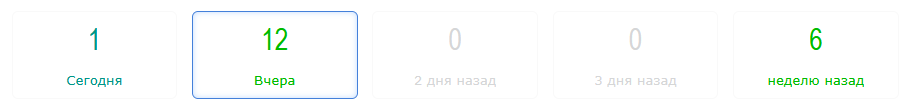

Улучшены инструменты управления статистикой и различные сдерживающие барьеры. Разделён подход к показу контента. Человекам почёт и уважение, для них всё и делается; хорошие боты особо не влияют на статистику (например, статья не считается прочитанной если контент просмотрен роботом); для плохих ботов ситуация накалилась. Каким-то доступ вообще закрыт, какие-то направляются на разные специальные страницы, где они там болтаются как в зеркальном кубе, для каждого робота появился свой сценарий что с ним делать. Googlebot - ходи смотри; Ahrefs - сначала пройди вот на эту страницу, потом куда хочешь; Majestic - а ну канай отсюда нелюдь, потеряйся в лабиринтах небытия и созвездиях безумия.

Развитие здесь системы учёта теперь позволяет видеть что кто-то пришёл из результатов поиска в Google с мобильного устройства посмотреть что появилось нового в приготовлении лосося с картохой. Для сайта хорошо что он появляется в информационном поле, количество лайков дизлайков и комментариев здесь не самоцель. Тем более что и на сильно известных сайтах комментируют тоже не очень-то. Просьбы поставить лайки здесь не будет, но поставить конечно можно.

Всё чаще возникают мысли начать делать сайт на .NET 9, но тут надо взвесить все «за» и «против». Так-то конечно я бы да, но сейчас поиск работы убивает все стремления, на это уходит очень много времени и сил.

Удалось выяснить что сегодня на сервер налетел некий ботнет, узнал про эти IP что они в чёрном списке спамеров. Эти IP уже заблокировал. Потом надо будет доработать страницы /banned и /restrictions чтобы если в бан попадёт человек, на страницах были инструменты подтвердить что это не робот. Время потраченное на разработку админьих инструментов пошло на пользу, как админ ресурса я должен знать обо всём что происходит на моей булочке.

Сегодня какая-то нездоровая активность, расценивать это иначе как атаку невозможно. Сервер выдерживает, сайт нормально переваривает, но это нездоровая канитель. Похоже тут ещё IP-спуфинг в деле. Это всё из United States.

Доработан учёт IP ботов и прочих сервисов которые не люди, проделана работа над дубликатами во всей статистике, рейтингах и не только. Улучшена страница обзора нарушений беспорядков. В ней надо ещё сделать чуть больше возможностей, сам иногда захожу посмотреть не натворил ли чего на сайте. Потом скорее всего появится виджет уведомлений что IP себя скомпрометировал. Ведь не каждого бота можно идентифицировать как бота и человека можно заподозрить что он бот, а он не бот. Вот. Некрасиво может получиться.

Чтобы проверить человек ли за неким IP, можно задать вопрос на который не каждый кожаный ответит, например «Сколько hardcore punk альбомов выпустил повар Н.В. Киркоров?». Правильный ответ будет наверное «Ты нормальный вообще?», но бот скорее всего не догадается нажать последовательность правильных кнопок чтобы получить статус «Verified». На это сейчас нет времени.

На сайт сейчас нет много времени, поиск работы всё отнимает, это просто ад, адище.

Почитаешь статьи или посмотришь видео от экспердов на тему продуктивной работы и что программировать эффективно можно не больше 4 часов, аж слеза наворачивается. Туловище говорит что ему 44 года и надоело программировать, он сейчас как менеджер. Что можно сказать, я сегодня присел за компуктер в 8 утра и столько всего сделано что не вспомнишь. Поиск работы, чтение технических статей, обучающие видео, задувание контента на двух своих сайтах, программирование, планирование, программирование, обкатка новой функциональности, программирование.

В таком режиме важно делать перерывы и отдыхать. Сегодня мог бы ещё пару часов дубасить код, но не надо, потому что расплата за авральный режим будет тяжкой.

Ситуация с поиском работы такая что это всё равно что стучаться в глухую бетонную стену. Вакансии есть, но откликов по ним 0. Даже обратной связи по отказам никакой. Что будет дальше предсказать невозможно, но пока ничего хорошего для себя не вижу.

Были планы много чего сделать, но всё остановилось. Что будет дальше неизвестно.

Наконец-то завершено заполнение всего сборника «Панк революция».

Нашлось время сделать табы по группам. Когда на одной странице была поддержка только одного набора табов - это очень примитивно, можно переключать что-то одно. В статьях и видео давно надо было сделать группировку категорий и комментариев в боковых колонках. Проматывая страницу колонка фиксируется и теперь табы позволяют показывать что нужно, не мешая другой группе табов, например [Статьи] [Лента] [Обновления] [Новости]. При необходимости это может улучшить навигацию по контенту.

Сайт посещают много посетителей с мобильных устройств, надо провести ревизию всё ли гуд с мобильной версией. За прошедшую неделю с сайтом сделано много всего, но это больше подкапотные изменения, сильно доработана статистика и админьи вещи. Ещё нужно много всего сделать, но лучше осмотреться куда двигаться дальше. Главное что архитектурные решения в порядке, остальное можно постепенно допиливать. Как минимум доработать показ комментариев.

Механизм статистики и учёта IP здесь постоянно совершенствуется и это даёт результаты. Подозрительные IP автоматически заносятся в реестр и SQL-запрос показывает дубликаты по части сети IP. Страница статистики показывает в каком часу какую страницу посетил IP и сколько раз. Всё это позволяет фильтровать роботов-негодяев и показывает честную статистику посещений, а не накрученную.

Если здесь отключить эту систему защиты - скорее всего сервер просто ляжет под нагрузкой, потому как недавний эксперимент уже показал что без защиты сайт бомбят тысячами запросов. 17 марта зафиксировано несколько десятков тысяч запросов в минуту. Виновные наказаны.

Сейчас ребята из Франции никак не могут угомониться, отправил их на пару недель подкрепиться круассанами.

За попытку SQL Injection бан минимум на год. Затейникам из Канады надо поискать другое поле для экспериментов.

Чем мне нра блекболыч - сайт ни о чём конкретно...

Только для сосайтников. Для просмотра нужно пройти

авторизацию.

Что-то делаешь, разрабатывашь, внедряешь, улучшаешь. Вроде всё хорошо. Только как всем этим пользоваться? Пойди-ка сам используй то что выдаёшь. И тут часто получаются удачные решения которые развивают тебя и проект, и вылезают неудачные решения которые нужно исправить и сделать выводы. Несколько лет назад начал так делать, ходить по сайту как посетитель, и это даёт результаты. А недавно узнал что такой подход называется Gemba Management.

Раньше для этого сайта многое делалось понятно и логичное с точки зрения разраба, но для пользователей местами коряво. Едешь например в поезде или просто ходишь по сайту и возникали мысли типа "и как этим пользоваться?". Когда сидишь за компуктером с админьими тулзами всё выглядит немного иначе, а когда сам в поле - совсем другая картина.

В общем, чтобы сделать годную вещь нужно быть слегка gembaнутым.

В библиотеке статей есть сводка обработанного контента (уже открытое для прочтения) и там не хватало возможности посмотреть что было изменено. Совершенно непонятно, появилось пятьсот миллионов тысяч статей как жарить курицу, хакеры опять взломали кошельки, обновилась линейка напольных аудиосистем или что вообще происходит? Сайт катится в кулинарный уголок или энциклопедию как запускать ракеты к Марсу? Вчера этот вопрос встал ребром и было мне видение что надо сделать красиво.

Через несколько часов обновление было готово, стало в разы понятнее что происходит с контентом и не нужно держать в голове что было добавлено и куда двигаться дальше. Надо будет выделить этот виджет в отдельный контрол и заняться студией контента.

Было (просто текст)

Стало (активные ссылки на список обработанного контента)

Занимаюсь контентом для сайта, замечаю что в окне какие-то синие всполохи. Думал может от видео отражения, посмотрел в окно - похоже проблесковые синие огни со стороны дороги... Чё-та дым или туман какой-то пошёл. Появился красный огонёк, небольшой такой, в районе крыши дома?.. Загорелся соседний дом. Огонь разгорелся меньше чем за минуту. Всё горело и трещало. Вот это ужас конечно. Пожарные потушили достаточно быстро.

Обновлено: пожарные уехали в 5:58. Жуткое дело эти пожары.

Статистическая сводка работы с контентом реально помогает оценить что хватит уже чахнуть над обновленими. Сегодня обработал уже 7 статей, куда тебе ещё? Займись чем-нибудь полезным.

Интерес почему кол-во посещений в Google Analytics, puls.lv и внутренней статистике сайта отличается на +-50 единиц и что можно улучшить вылилось в несколько дней работы. В результате появился реестр IP ботов, новые админьи страницы статистики, расширенные возможности учёта и отображения статистики по контенту. Это будет внедрено в инструменты управления контентом. Например, в библиотеке статей.

Статистические данные это огроменный объём информации, даже для этого небольшого сайта. Какие массивы информации обрабатывают соцсети, Google, финансовые, страховые, медицинские проекты и т. д. даже представить страшно.

Здесь статистикой пока особо заморачиваться не стоит, будет полезнее развивать работу с контентом.

Список IP ботовСистема управления реестром IP ботов готова и уже работает на моих сайтах. Получилось нормально так. Можно импортировать из файла, экспортировать в файл, добавлять вручную, редактировать, удалять, помечать что это за бот (поисковый или «чёрный»), что с ним делать, страна и регион, можно очистить весь список, дубликаты при добавлении обрабатываются. Всё это пойдёт на пользу статистике посещений и усилению защиты от зловредов. Могу заблокировать на блекболыче весь Китай, мышь не проскочит. У меня с этим строго. Только времени сейчас на это нет.

Осталось собрать список IP в текстовый файл и актуализировать этот реестр, это только вопрос времени. Потом может сделаю общедоступный API. Потому что я добрый.

Работа над статистикой посещений и защитой от роботов-ебоботов в очередной раз поставила вопрос о создании реестра IP с ботами. Есть полезные роботы, которые нужны для сбора информации, поисковые боты, системы анализа сайта, так называемые «белые», и есть вредоносные, которые тысячами запросов бомбят сервер, портят статистику, занимают ресурсы и вообще. Из-за таких негодяев решено создать список «чёрных» ботов для фильтрации трафика.

На момент написания этой заметки блеболыч зафиксировал 1751 уникальных посетителя и 3050 загрузок страниц. Не все из уникальных человеки. У меня написан механизм синхронизации данных, и когда будет сделан список ботов - стирать статистику не нужно, можно отфильтровать IP по группам (человек, поисковик, rss crawler и т. д.). Этих ботов тысячи, миллионы их, и охватить всех цели нет. Но механоидов из Сингапура и прочей Азии, Германии, Нидерландов пора секануть, надоели они уже. Всех вредных ботов-гадёнышей в концентрационный лагерь.

Когда читаешь как успешный бизнесмен построил бизнес из говна и палок, и зарабатывает миллионы, вспоминается:

- Как вы стали миллионером?

- Купил яблоко, помыл его и продал. Купил 2 яблока, помыл и продал.

А потом умер мой дядя, миллионер.

Сегодня засосал движ со статистикой посещений. Учёт был улучшен (уникальные, кол-во загрузок страниц), и расследование показало что сейчас на блекболыче 27.770.000+ строк почасовой статистики. Открытым остаётся вопрос как определять что посетитель это человек, а не бот. После обновления учёта посещений боты мигом ломанулись в брешь защиты и в первые часы дали огня. В некоторые моменты было несколько тысяч посещений в минуту которые зафиксировались, хорошо что вовремя накатил патч. На блекболыче есть механизм синхронизации статистики с учётом дубликатов, потом надо будет заняться очисткой сегодняшнего дня.

« 1

2

3

4

5

»